麻省理工学院提供了reddit的人工智能数据,现在它只考虑谋杀

对一些人来说,“人工智能”一词让人联想到噩梦般的景象——也许是04年威尔·史密斯电影《我,机器人》中的某些东西,或者是前机器时代的结局——就像一只靴子砸破电脑屏幕的玻璃,永远踩在人的脸上。即使是研究人工智能的人,也对该领域的最终目标——人工通用智能或模仿人类思维模式的人工系统——有着健康的尊重。计算机科学家斯图尔特·拉塞尔(Stuart Russell)写了一本关于人工智能的教科书,他用自己的职业生涯思考了当一台机器的设计者将其导向一个目标时会出现的问题,而没有考虑其价值观是否与人类的价值观一致。

近年来涌现了许多组织来应对这一潜力,其中包括OpenAI,一个由技术亿万富翁埃隆·马斯克(Elon Musk)创建(然后离开)的工作研究小组,目的是“构建安全[AGI],确保AGI的利益得到尽可能广泛和均匀的分配。“它说什么,人类害怕通用人工智能,因为它可能认为我们残忍、不值得,因此值得毁灭(在其网站上,开放人工智能似乎没有定义“安全”的含义。)

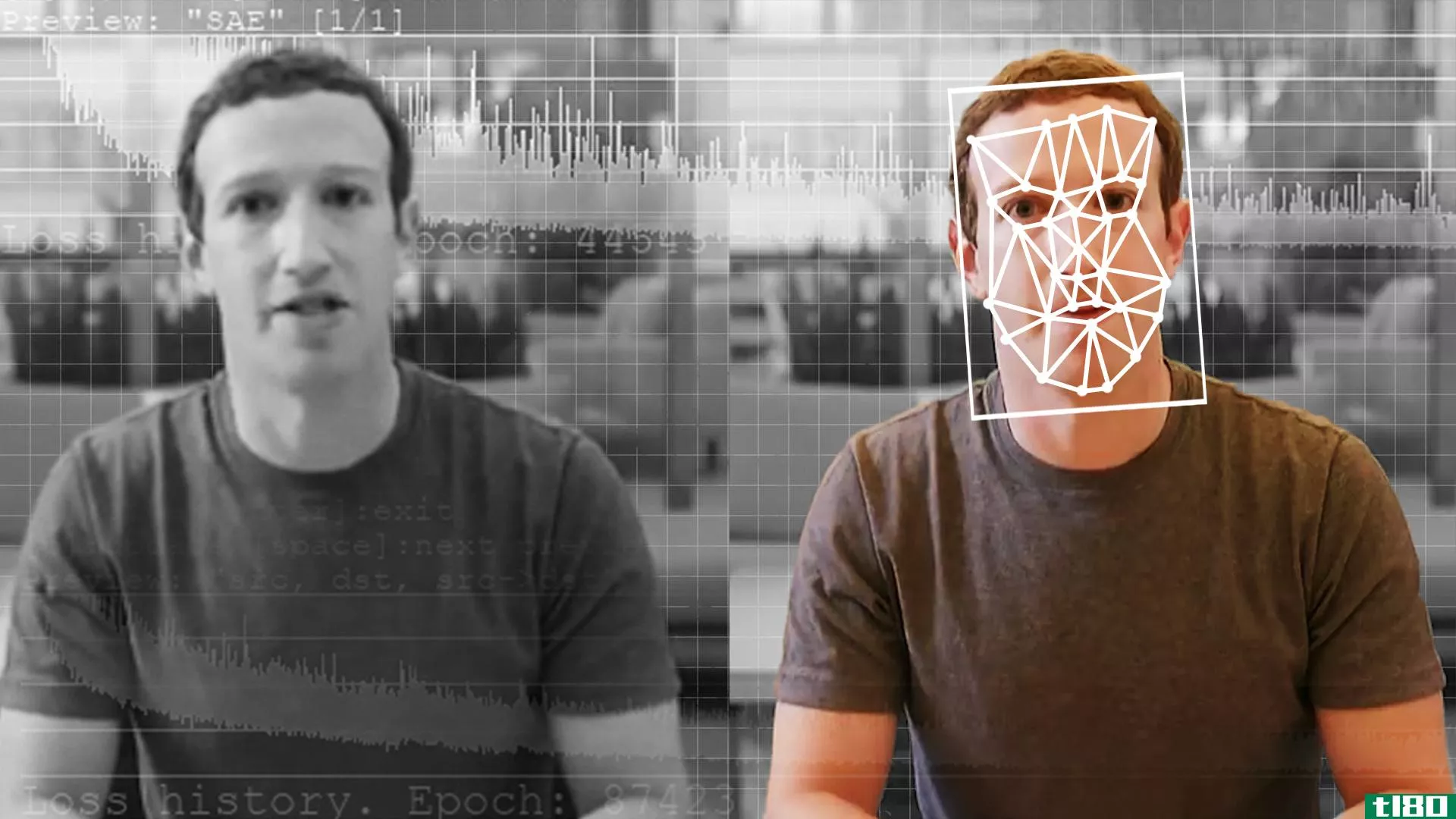

本周,麻省理工学院的研究人员公布了他们的最新发明:诺曼,一种不安的人工智能(是的,他是以希区柯克《精神病》中的人物命名的。)他们写道:

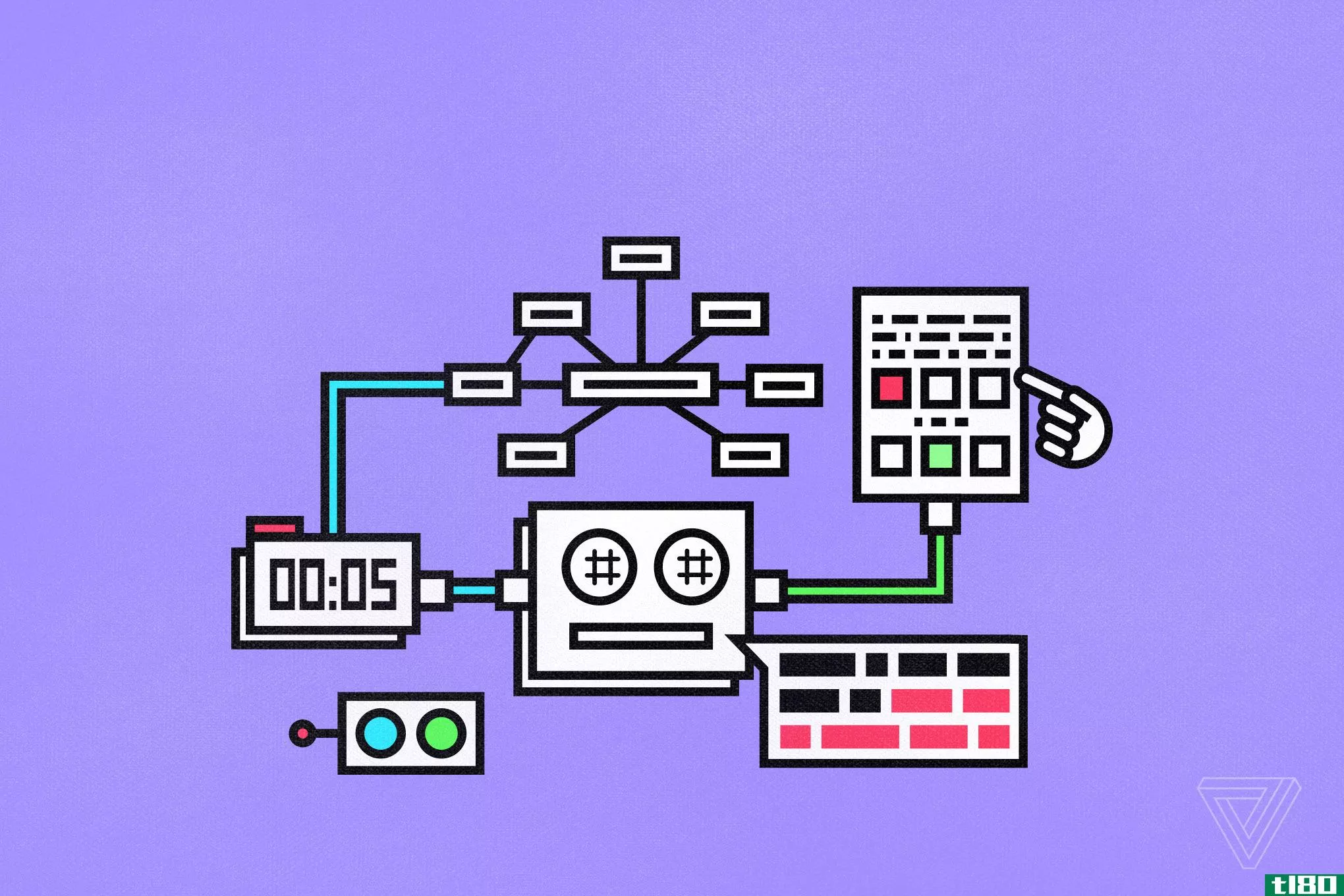

Norman is an AI that is trained to perform image captioning, a popular deep learning method of generating a textual description of an image. We trained Norman on image capti*** from an infamous subreddit (the name is redacted due to its graphic content) that is dedicated to document and observe the disturbing reality of death. Then, we compared Norman’s resp***es with a standard image captioning neural network (trained on MSCOCO dataset) on Rorschach inkblots; a test that is used to detect underlying thought disorders.

虽然有一些关于罗夏测验是否是衡量一个人心理状态的有效方法的争论,但不可否认,诺曼的答案令人毛骨悚然。你自己看看吧。

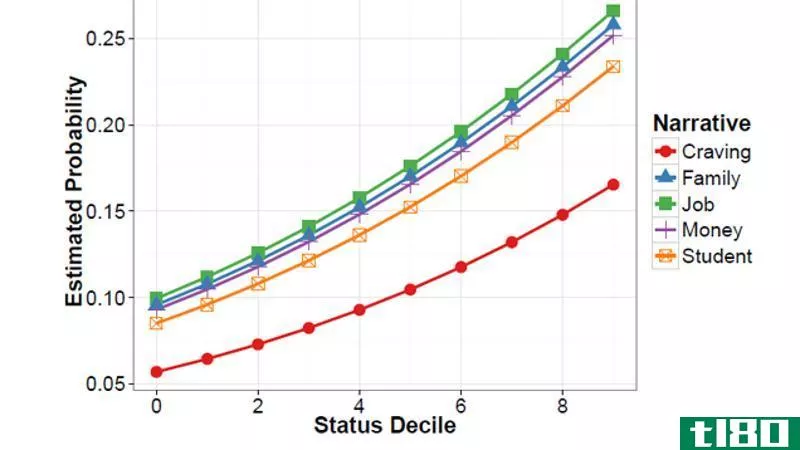

这项实验的目的是要表明,如果你根据有偏见的数据训练任何人工智能,那么它是多么容易产生偏见。研究小组明智地没有猜测接触图形内容是否会改变人类的思维方式。他们也用同样的方法做了其他实验,用人工智能写恐怖故事,创造恐怖图像,判断道德决定,甚至诱发同理心。这种研究很重要。我们应该像对任何其他技术一样,对人工智能提出同样的问题,因为它太容易造成意外后果,伤害到系统设计时没有看到的人。当然,这是科幻小说的基础:想象可能的未来,展示什么可以引领我们到达那里。伊萨克·阿西莫夫·基夫写了“机器人三定律”,因为他想想象如果违反了这些定律会发生什么。

尽管人工智能不是一个新的领域,但正如吉迪恩·刘易斯·克劳斯(Gideon Lewis Kraus)在《****》杂志上所写的那样,我们离生产能够“展示一种隐含的、解释性的设施”还有很长很长的路要走。但它仍然没有经历那种导致学科成长的清算。你还记得,物理学给了我们***,每个成为物理学家的人都知道,他们可能会被要求帮助创造一些能够从根本上改变世界的东西。计算机科学家也开始意识到这一点。今年在谷歌,5000名员工**,许多员工辞职,因为谷歌参与了五角大楼的Maven项目,该项目利用机器学习提高无人机打击的准确性。

诺曼只是一个思维实验,但它提出的关于机器学习算法根据有偏见的数据做出判断和决定的问题是紧迫和必要的。例如,这些系统已经用于信贷承销,决定贷款是否值得担保。如果算法决定你不应该买房子或汽车怎么办?你向谁上诉?如果你不是白人,一个软件预测你会因此而犯罪呢?有很多很多悬而未决的问题。诺曼的任务是帮助我们找出他们的答案。

- 发表于 2021-08-24 09:44

- 阅读 ( 108 )

- 分类:互联网

你可能感兴趣的文章

使用android智能手机时保持隐私的8种方法

...Signal和Telegram等应用程序只能通过数据连接工作,但它们提供了最多的隐私。 ...

- 发布于 2021-03-17 02:25

- 阅读 ( 245 )

什么是机器学习算法?他们是这样工作的

... 与此同时,麻省理工学院研究人员乔伊·布奥兰维尼回忆说,在研究面部识别技术时,为了让软件认出她,她经常需要戴上白色的面具。为了解决这样的问题,Buolamwini和其他IT专业人...

- 发布于 2021-03-23 07:51

- 阅读 ( 172 )

如何无怨无悔地整理数据(但保留所需内容)

...你的搜索技巧。学习一些智能搜索技巧,为任何在线资源提供近乎即时和准确的匹配。你可能会惊讶地发现,偶然性经常会在正确的时间给你带来正确的信息。 ...

- 发布于 2021-03-25 06:52

- 阅读 ( 193 )

你真的想让亚马逊亚历山大报警吗?

...这意味着,如果我们继续使用这些服务,过去完全保密的数据——我们与警方的对话——可能不再保密。 ...

- 发布于 2021-03-25 13:37

- 阅读 ( 211 )

苹果现在可以让你自动将icloud照片库转移到谷歌照片

...iPhone跳转到Android或者只想使用Google照片,这个工具应该提供一个简单的方法,可以快速地将你所有的照片转移到服务中,而不必自己重新上传。点击几下,你的照片就会在他们去新家的路上。只要确保你有足够的谷歌存储空间...

- 发布于 2021-04-16 00:35

- 阅读 ( 146 )

reddit欠版主的不仅仅是更新的仇恨言论政策

...62.7%,第二季度达到50亿小时。(莎拉佩雷斯/TechCrunch) 麻省理工学院(MIT)将一个被高度引用的数据集下线,该数据集训练人工智能系统,使其有可能使用种族主义、厌恶**和其他有问题的术语来描述人们。该协会还敦促开发人...

- 发布于 2021-04-18 10:39

- 阅读 ( 174 )

openai将开始销售其文本生成技术,首批客户包括reddit

以减轻人工智能潜在危害为目标的非营利性研究实验室OpenAI宣布了其首个商业产品:一个AI文本生成系统,该机构此前警告说,该系统过于危险,无法共享。 去年2月,实验室发布了文本生成器GPT-2,OpenAI在文本生成方...

- 发布于 2021-04-19 02:23

- 阅读 ( 141 )

脸谱网’到2020年,中国控制假货的问题只会变得更糟

...庞大的类别,以至于不清楚它是否有任何意义,”哈佛-麻省理工学院(Harvard-MIT)伦理和人工智能治理计划(AI initiatim)的前主任蒂姆•黄(Tim Hwang)告诉《边缘》(Verge)。“如果我有我的druthers,我不确定我是否有,我会说...

- 发布于 2021-04-20 15:31

- 阅读 ( 170 )

reddit、twitch和imgur建立了一个名为derp的研究伙伴关系

...人员所需的信息。DERP说,斯坦福大学、哥伦比亚大学、麻省理工学院和其他几所大学的研究人员已经在研究它的数据。

- 发布于 2021-04-27 03:17

- 阅读 ( 83 )

我们如何阻止杀手利用社交媒体?

...eynep Tufekci提出这可能是事实,并根据有关**的指导方针,提供了报道大规模谋杀而不传播传染病的道德方法。这是有先见之明的;美国联邦调查局(FBI)去年发布的一份报告显示,在过去的14年里,枪击事件不断增多。从2000年到...

- 发布于 2021-05-01 05:14

- 阅读 ( 141 )