会犯错的笨机器人实际上帮助人类解决问题

最新研究表明,当人类与不太聪明的机器人一起工作时,他们比只与其他人一起工作时更善于解决问题。这一发现有助于提高数字化工作场所的生产率。这是迈向了解自动化未来的一步,在自动化未来,机器人可能会帮助人们做出更好的决策。当然,天网的创造者们可能也是这么想的。

我们自动化的未来已经到来——至少在某种程度上。算法和智能设备帮助人们选择买什么,读什么,看什么,走哪条路。但是耶鲁大学的社会科学家尼古拉斯·克里斯塔基斯和Hirokazu Shirado想在更大的范围内理解这意味着什么:机器是如何改变人类相互作用的?机器人同事能帮助人类更有效地合作吗?

为了找到答案,克里斯塔基斯和西拉多挑战人们,让他们解决一个只在人类群体中工作的难题,或者在包括伪装**类玩家的机器人的群体中工作。就在那时,研究人员做出了一个矛盾的发现。混合人类机器人团队比纯人类团队更快地解决了挑战,但只有在机器人偶尔做出完全随机的决定时。根据今天发表在《自然》杂志上的研究,基本上,哑巴机器人不稳定的行为使人类摆脱了惯常的习惯,并引导他们找到更有创意的解决方案(这并不是无痛的——混合组的人喜欢胜利,但他们发现自己不可预知的机器人队友很烦人。)

“特别令人兴奋的是,在我们现在的世界,当然在未来,人们和算法将一起做决定,”伊恩·库津说,他在马克斯·普朗克研究所研究集体行为,没有参与这项研究我们正努力以更定量的方式来理解这些系统——让我们从科学的角度来理解集体决策是如何做出的。”

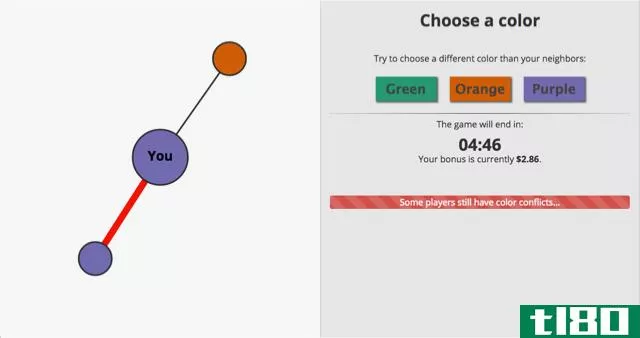

Christakis和Shirado通过Amazon Mechanical Turk招募了4000人,Amazon Mechanical Turk是一个在线平台,用户可以通过付费完成在线任务。他们将参与者分成230个不同的小组,每组约20人。每个玩家都要控制一组相连点中一个点的颜色。圆点可以是绿色、橙色或紫色。

任务是:由20名玩家组成的小组必须确保他们网络中的每一个点都有不同于其邻居的颜色。如果五分钟过去了,还有,比方说,两个紫色的旁边,整个团队都输了。而且他们失去了他们的奖金:每个玩家只要出现就可以得到2美元的奖金,而3美元的奖金随着团队解决问题的时间越长价值就会下降。挑战在于玩家只能看到自己的圆点,以及他们的近邻——他们无法缩小并看到整个阵列。这是一个游戏化的隐喻:我们可以看到我们的个人任务,以及坐在我们旁边的人的任务——但更难看到更大的图景。

有些团体完全由人组成。但其中一些人用三个机器人代替了三个人。机器人被设定为选择最不可能与近邻冲突的颜色。但在某些情况下,研究人员在机器人程序中添加了一点“噪音”,或随机变化。所以偶尔-10%的时间是“低噪音”机器人,30%的时间是“高噪音”机器人-一些机器人会无缘无故地随机改变他们的点的颜色。

有时,这些机器人会在阵列边缘取代人类玩家,在那里他们没有很多邻居,有时他们会被放在中间——他们有很多邻居。其他时候,他们被随机放在球场上。事实证明,拥有低噪音机器人的团队比所有人类团队或拥有高噪音机器人的团队解决难题的速度要快得多。这似乎是个奇怪的结果。为什么在网络中的几个关键位置添加随机变量会使团队的表现变得更好?

向系统中添加错误或不合逻辑的行为可能是有益的,这种想法在自然界中实际上有一些先例。例如,如果你一代又一代都有完美的生殖能力,那么你就不会得到进化,克里斯塔基斯说所以在繁殖过程中你需要一点噪音,一点突变来让有机体适应新的环境,”他说。

同样地,如果人类玩家在着色挑战中顽固地坚持他们的邻居的完美颜色,他们可能永远也解决不了这个难题。”每个人都在想,“我已经完成了我的工作,是其他地方的某个**没有完成他们的工作!”但与此同时,那家伙在想,‘我已经完成了我的工作!’克里斯塔基斯说因此,在这种情况下,每个人都被锁定在他们在当地似乎能做的最好的事情上,但在全球范围内,他们没有做最好的事情。”

为了达成全球解决方案,玩家们必须容忍犯错,或者选择一种让他们与邻居发生冲突的颜色。即使仅仅是三个行为更不稳定的机器人,也让远在网络中的人类明白,这种策略可以解锁那些不明显的解决方案。

由此推论,推动像沃森和AlphaGo这样的超级智能人工智能,可能会被误导。即使是“纯朴”的人工智能——克里斯塔基斯也没有动手,他称自己的机器人为哑巴——可以影响人类的行为,在这种情况下,可以提高人类的表现。”人工智能不需要那么聪明,因为人类已经很聪明了,但我们需要一些帮助也许人工智能或机器人可以帮助人们自助。”

库津说,这一发现非常发人深省他们表明,网络中的这些机器人实际上可以极大地改变人类做出决定的能力——即使他们不知道自己在那里,”他说。它已经在发生——算法影响着我们每天的决策。”这是我们人类需要开始面对的问题,因为如果我们不从科学、伦理的角度来看待这个问题,那么我们就不理解它。如果我们不理解它,那么它就可能被滥用。“这就是为什么像这样的研究如此重要,他说。

例如,克里斯塔基斯并不害怕一个不成熟的机器人会诱使人类做出更好的决定的未来。”他开玩笑说:“与超级智能人工智能相比,我当然会觉得哑巴人工智能更安全。”我觉得这些机器人比天网安全多了。”

- 发表于 2021-05-11 05:43

- 阅读 ( 182 )

- 分类:互联网

你可能感兴趣的文章

20个ted关于编程的演讲每个人都必须观看

... 当然,在那之前我们还有其他事情要担心,比如机器人接管我们的工作时会发生什么。 ...

- 发布于 2021-03-12 21:17

- 阅读 ( 261 )

人工智能的问题是:机器在学习东西,但不能理解它们

...蘑菇进行分类的神经网络利用了以交替顺序呈现的数据,实际上并没有学习到输入图像的任何特征。” 其中一些解决方案听起来可能很聪明,但这些神经网络都不明白它们在做什么。他们被分配了一个目标,并学会了实现它的...

- 发布于 2021-04-04 05:25

- 阅读 ( 146 )

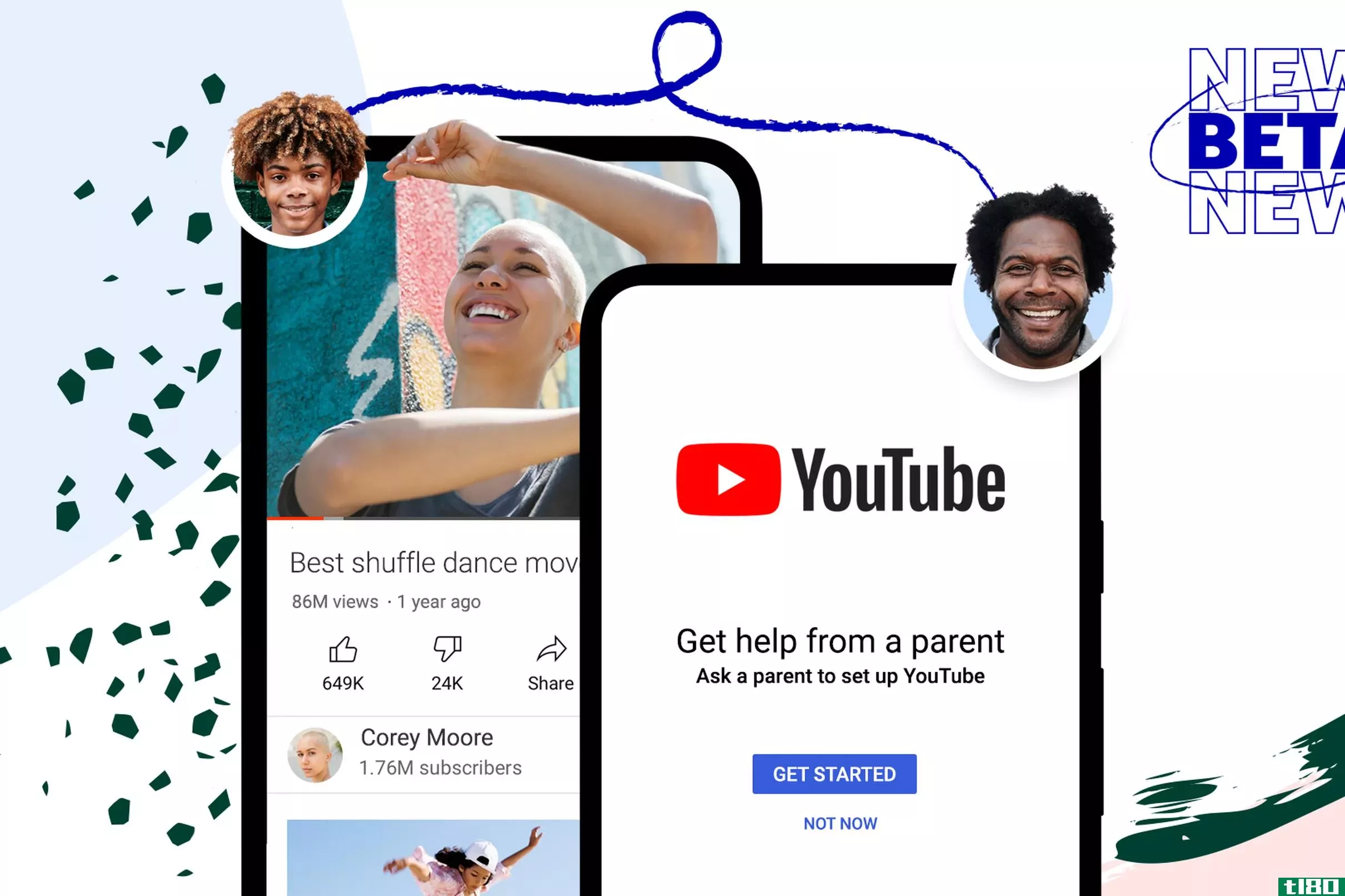

youtube的“监督体验”帮助家长选择孩子能看到的内容

...器学习的系统。YouTube知道它不会是完美的,承认它“会犯错”,我们在儿童应用程序中看到过这种情况。因此,家长不应该认为这是一个“定了就忘了”的解决办法。他们仍然需要保持警惕。 尽管如此,这些新的内容选项应该...

- 发布于 2021-04-16 13:58

- 阅读 ( 214 )

曼达洛人是一个电子游戏英雄,新的一集终于出现了困难

...易犯错的人类战士,而是(至少在理论上)更可靠的战斗机器人。 不过,黑暗骑兵的起源更为实际。《黑暗势力》是卢卡斯艺术公司首次尝试**《星球大战》第一人称射击游戏,该游戏在很大程度上借鉴了《末日》的流行,...

- 发布于 2021-04-18 17:59

- 阅读 ( 405 )

机器人正在学习如何像动物一样跛行

机器人在工作不太正常的时候看起来最逼真。看着一个蜘蛛般的机械生物失去肢体后挣扎着继续前行,感觉就像看着一只受伤的动物,有一个很大的区别:动物一生都在想如何适应受伤,更不用说数百万年的进化了。机器人可能...

- 发布于 2021-04-30 00:54

- 阅读 ( 126 )

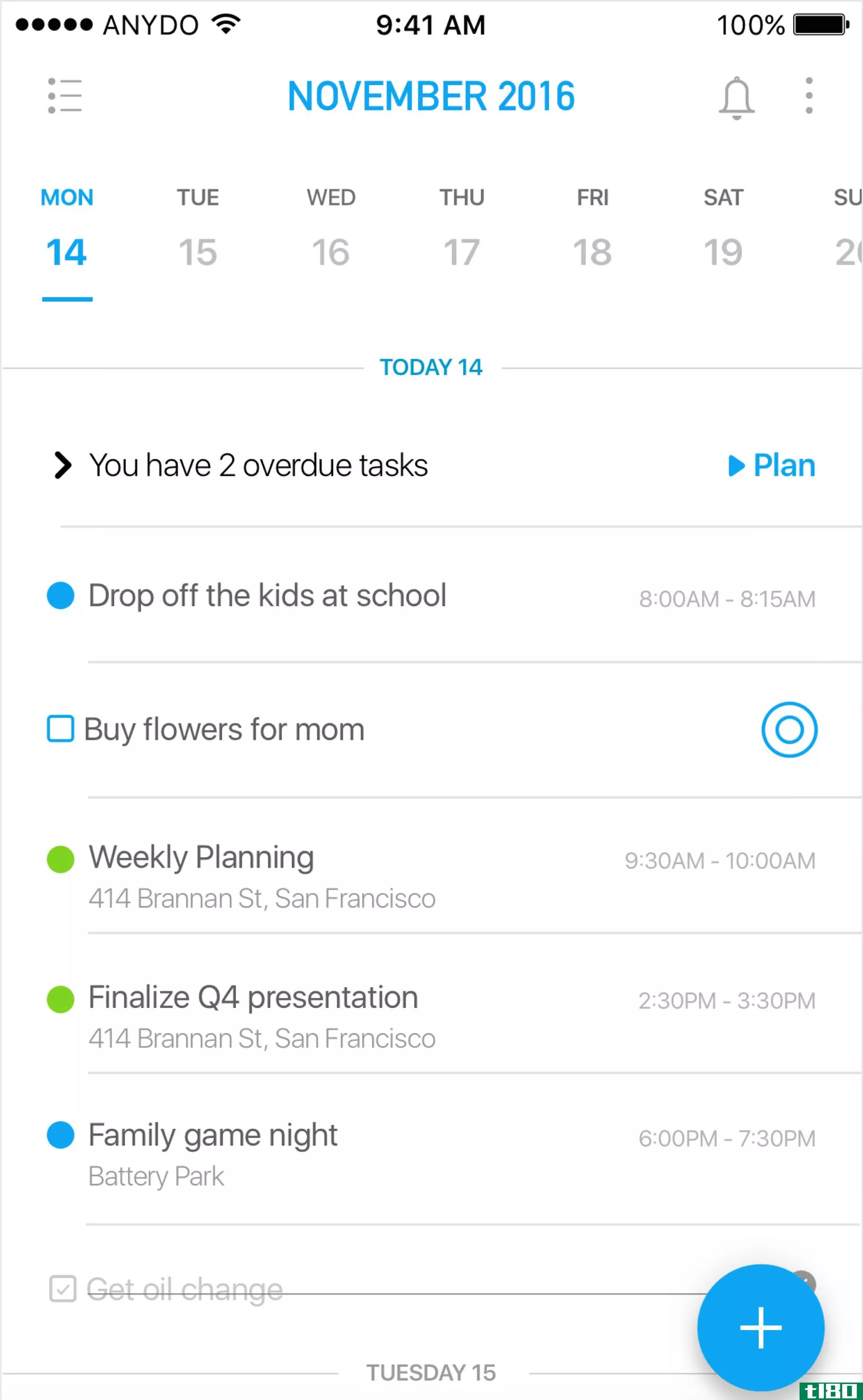

any.do是将智能助手添加到您的待办事项列表中

...任务时,公司的服务器会对它进行分析,看它是否是聊天机器人或人工助手可以帮助你完成的任务。如果是这样,就会弹出一个按钮,与机器人或人类聊天,然后由机器人或人类替你处理。 这就是你,就像几乎所有尝试过虚拟...

- 发布于 2021-05-08 17:47

- 阅读 ( 110 )

如何处理工作中的大麻烦

...改变,以消除问题。你可能会被诱惑跳过死后的检查,但实际上这是你经历中最有价值的部分。如果你从你不可避免的错误中吸取教训,你会把你的事业置于危险之中。我经常认为,我从自己的错误中学到的东西比从任何其他来...

- 发布于 2021-05-20 19:14

- 阅读 ( 156 )

数字时代的f**king指南

...了公共错误的人的道歉。当我们输入互联网的记录时,它实际上变成了公共信息。即使你发了一条信息给一群特定的人,如果它引起了少数人的愤怒,它也会在你的圈子之外找到出路,招致愤怒的互联网的愤怒,甚至会损害你在...

- 发布于 2021-05-26 02:26

- 阅读 ( 182 )

如何在不惹恼服务员的情况下把食物送回餐馆

...品服务公民来帮助我提供他们的两分钱。这是我学到的。犯错的人可能各不相同,所以不要以为你没有犯错悉尼指出,尊重是关键,但情况会有所不同,你应该记住,你可能是真正犯错误的人:解释问题并寻求解决方案。如果这...

- 发布于 2021-05-27 00:24

- 阅读 ( 174 )