一个机器学习工具能(也不能)告诉我们什么是人工智能偏见

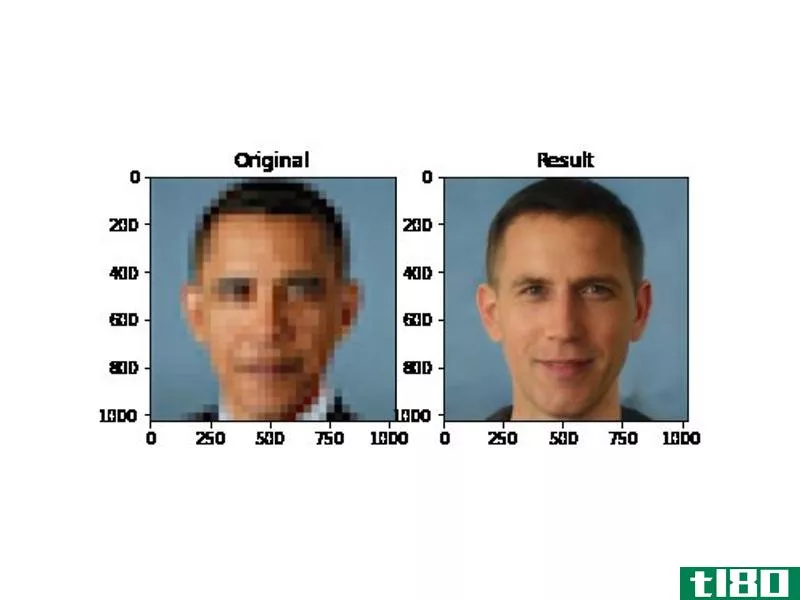

这是一个惊人的图像,说明了人工智能研究根深蒂固的偏见。将美国第一位黑人总统巴拉克奥巴马(Barack Obama)的一张低分辨率照片输入到一个算法中,该算法设计用于生成不相关的人脸,输出的是一个白人。

也不仅仅是奥巴马。用同样的算法,从低分辨率的输入中生成女演员Lucy Liu或女议员Alexandria Ocasio Cortez的高分辨率图像,得到的人脸看起来明显是白色的。正如一条引用奥巴马例子的热门推特所说:“这张图片充分说明了人工智能中偏见的危险。”

但是,是什么导致了这些输出,它们真正告诉我们什么是人工智能偏差?

首先,我们需要稍微了解一下这里使用的技术。生成这些图像的程序是一种称为PULSE的算法,它使用一种称为放大的技术来处理视觉数据。升级就像你在电视和电影中看到的“缩放和增强”比喻,但是,与好莱坞不同的是,真正的软件不能无中生有地生成新数据。为了将低分辨率图像转换成高分辨率图像,软件必须使用机器学习来填补空白。

在脉冲的情况下,做这项工作的算法是StyleGAN,它是由NVIDIA的研究人员创建的。虽然您以前可能没有听说过StyleGAN,但您可能对它的工作很熟悉。它的算法负责**那些你可以在像Th这样的网站上看到的怪异逼真的人脸isPersonDoesNotExist.com;人脸非常逼真,经常被用来**虚假的社交媒体资料。

PULSE使用StyleGAN来“想象”像素化输入的高分辨率版本。它不是通过“增强”原始低分辨率图像,而是通过生成一个全新的高分辨率人脸,当像素化后,看起来与用户输入的一样。

这意味着每一个分离的图像可以以多种方式放大,就像一套单一的原料**不同的菜肴一样。这也是为什么你可以用PULSE来观察厄运的家伙,或者Wolfenstein 3D的英雄,甚至是哭泣的表情符号在高分辨率下的样子。并不是像“缩放和增强”的比喻那样,算法在图像中“寻找”新的细节;而是发明新的面孔,还原为输入数据。

这类工作在理论上已经有几年的可能了,但是,就像人工智能领域经常发生的情况一样,当一个易于运行的代码版本在本周末被在线分享时,它吸引了更多的读者。就在那时,种族差异开始出现。

脉搏’研究人员说,这一趋势很明显:当使用该算法放大像素图像时,该算法通常会生成具有白种人特征的人脸。

该算法的创造者在Github上写道:“看起来PULSE产生白脸的频率比有色人种的频率要高得多。”。“这种偏见很可能是从StyleGAN在[…]上训练的数据集继承而来的,尽管可能还有其他我们不知道的因素。”

换言之,由于StyleGAN是在’如果你想得到一张像像素化输入图像的脸,它默认为白色特征。

这个问题在机器学习中非常常见,这也是人脸识别算法在非白人和**人脸上表现较差的原因之一。用来训练人工智能的数据往往偏向于一个单一的人口统计学,即白人,当一个程序看到的数据不在这个人口统计学中时,它的表现就很差。无独有偶,是白人主导了人工智能研究。

但是,奥巴马的例子究竟揭示了什么样的偏见,以及它所代表的问题如何得到解决,这些都是复杂的问题。事实上,它们是如此复杂,以至于这个单一的图像在人工智能学者、工程师和研究人员中引发了激烈的分歧。

在技术层面上,一些专家甚至不确定这是数据集偏见的一个例子。人工智能艺术家马里奥·克林格曼(Mario Klingemann)认为,应该归咎于脉冲选择算法本身,而不是数据。克林格曼指出,他能够使用StyleGAN从同一像素化的奥巴马图像生成更多非白色输出,如下所示:

克林格曼说,这些人脸是用“相同的概念和相同的StyleGAN模型”生成的,但不同的搜索方法产生的,他说,我们不能仅仅从几个样本来判断算法。他告诉《边缘报》说:“可能有数百万张可能的脸都会缩小到相同的像素图案,而且都是同样‘正确的’。”。

(顺便说一句,这也是这样的工具不太可能用于监视目的的原因。通过这些过程创建的面是虚构的,如上面的例子所示,与输入的基本事实关系不大。然而,这并不是说巨大的技术缺陷阻止了警方在过去采用技术。)

但不管是什么原因,算法的输出似乎是有偏差的——这是研究人员在工具被广泛使用之前没有注意到的。这说明了一种不同的、更普遍的偏见:一种在社会层面上运作的偏见。

黛博拉·拉吉是人工智能领域的研究人员,他告诉《边缘》杂志,这种偏见在人工智能领域太过典型了。拉吉说:“鉴于有色人种的基本存在,忽视对这种情况的测试是令人震惊的,这可能反映了我们继续看到的关于谁能够建立这样的系统的多样性的缺乏。”。“有色人种不是异类。我们不是‘边缘案例’的作者,我们可以忘记。”

一些研究人员似乎只热衷于解决偏见问题的数据方面,这一事实引发了有关奥巴马形象的更大争论。Facebook首席人工智能科学家Yann LeCun在推特上回应称“当数据有偏差时,ML系统有偏差,并补充说,这种偏见是一个更严重的问题“在一个部署的产品比在学术论文”的含义是:让我们不要太担心这个特定的例子。

许多研究人员,包括拉吉在内,对勒坤的框架提出了异议,指出AI中的偏见受到更广泛的社会不公正和偏见的影响,仅仅使用“正确”的数据并不能处理更大的不公正。

另一些人指出,即使从纯技术修复的角度来看,“公平”的数据集也往往不是。例如,准确反映英国人口结构的人脸数据集将以白人为主,因为英国以白人为主。在这些数据上训练的算法在白脸上比在非白脸上表现得更好。换句话说,“公平”的数据集仍然可以创建有偏见的系统。(在Twitter上的一篇帖子中,勒坤承认AI偏见有多种原因。)

Raji告诉The Verge,她也对LeCun的建议感到惊讶,LeCun建议研究人员应该比生产商业系统的工程师更少地担心偏见,这反映了行业最高层缺乏意识。

拉吉说:“Yann LeCun领导着一个工业实验室,该实验室以研究许多应用研究问题而闻名,他们经常寻求将这些问题生产出来。”。“我真的不明白,在这个职位上,为什么有人不承认研究在建立工程部署规范方面的作用。”

当《边缘》杂志就这些评论联系到勒坤时,他指出,他在Facebook内外帮助建立了许多关注人工智能公平性和安全性的团体,包括人工智能方面的合作伙伴关系。他对《边缘》杂志说:“我绝对从来没有,从来没有说过,甚至暗示过,研究不起作用的事实就是建立规范。”。

然而,许多商业人工智能系统是直接从研究数据和算法中构建的,没有任何种族或性别差异的调整。在研究阶段未能解决偏见问题只会使现有问题长期存在。

从这个意义上说,奥巴马形象的价值不在于它暴露了单一算法中的单一缺陷;而在于它在直观的层面上传达了人工智能偏见的普遍性。然而,它隐藏的是,偏差问题比任何数据集或算法都要严重得多。这是一个普遍存在的问题,需要的不仅仅是技术修复。

正如一位研究人员Vidushi Marda在Twitter上对该算法产生的白脸做出的回应:“如果需要明确说明的话——这不是要求数据集‘多样化’或性能‘提高准确性’——这是要求对设计、开发、管理和应用程序的机构和个人进行根本性的重新考虑,首先部署这项技术。”

更新,星期三,6月24日:这篇文章已经更新,包括从雅恩乐坤补充意见。

- 发表于 2021-04-19 04:02

- 阅读 ( 149 )

- 分类:互联网

你可能感兴趣的文章

深度学习vs.机器学习vs.人工智能:它们是如何结合在一起的?

...技领域的下一件大事是机器学习。还是深入学习?也许是人工智能。如果你发现自己纠结于三者之间的差异,你并不孤单。 ...

- 发布于 2021-03-22 20:26

- 阅读 ( 263 )

什么是机器学习算法?他们是这样工作的

人工智能和机器学习产生了我们今天在技术工业中看到的许多进步。但是机器是如何被赋予学习能力的呢?此外,我们这样做的方式是如何导致意想不到的后果的? ...

- 发布于 2021-03-23 07:51

- 阅读 ( 167 )

你能认出赝品吗?5个免费在线测试,检测和了解虚假信息

... 使用人工智能(AU),人们现在可以操纵视频和图像到可怕的程度。它们被称为深赝品,看起来几乎是真的。由于人工智能可以创造令人兴奋的作品,你需要知道一个虚假的图...

- 发布于 2021-03-30 05:07

- 阅读 ( 268 )

有人能分辨出他们是假的吗?

...克隆目前正处于发展阶段,许多公司正在开发工具。类似人工智能和描述有在线演示任何人都可以尝试免费。你只需录制屏幕上出现的短语,几分钟后,你的声音模型就被创建出来了。 你可以特别感谢人工智能,深度学习算法...

- 发布于 2021-04-01 21:18

- 阅读 ( 145 )

人工智能的问题是:机器在学习东西,但不能理解它们

现在每个人都在谈论“人工智能”。但是,不管你是在看Siri、Alexa,还是仅仅看智能**键盘上的自动更正功能,我们并不是在创造通用的人工智能。我们正在创建可以执行特定、狭义任务的程序。 电脑不能“思考” 每当一家...

- 发布于 2021-04-04 05:25

- 阅读 ( 145 )

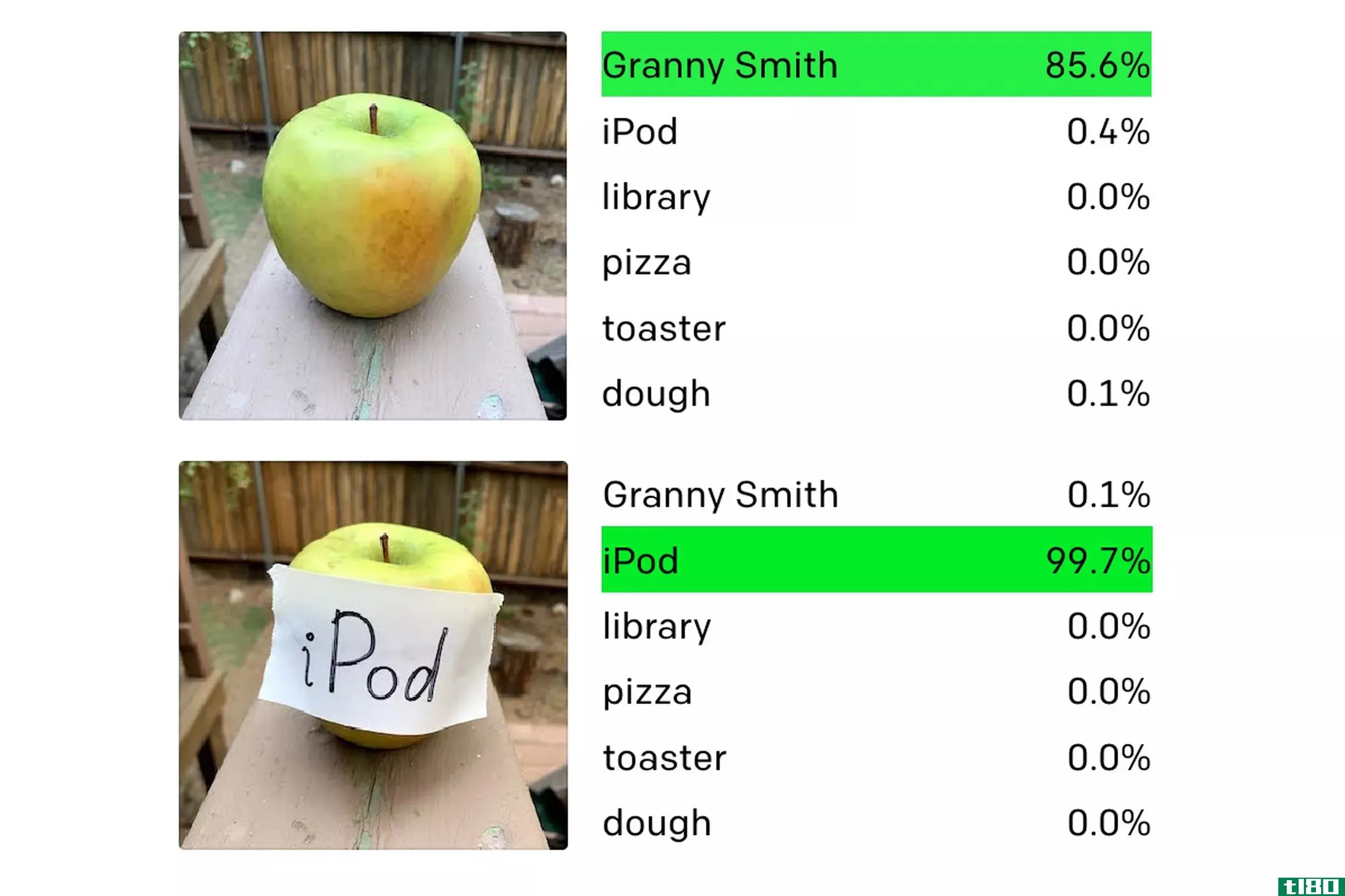

openai最先进的机器视觉ai被手写的笔记愚弄了

...警告的情况下改变车道。这种攻击对从医疗到军事的各种人工智能应用都是一种严重的威胁。 但至少在目前,这种特定攻击所带来的危险是不需要担心的。讨论中的OpenAI软件是一个名为CLIP的实验系统,没有部署在任何商业产品...

- 发布于 2021-04-16 01:24

- 阅读 ( 123 )

使用人工智能根据姓名来识别性别的服务看起来极为偏颇

...吃一惊。 Genderify是一项新的服务,它承诺在人工智能的帮助下,通过分析某人的姓名、电子邮件地址或用户名来识别其性别,它看起来肯定属于后者。该公司上周推出了产品搜索,但由于用户发现其算法存在偏差和...

- 发布于 2021-04-18 16:45

- 阅读 ( 154 )

人工智能专家说,对声称能预测犯罪行为的算法的研究必须结束

一个由人工智能研究人员、数据科学家和社会学家组成的联盟呼吁学术界停止发表声称利用面部扫描和犯罪统计等数据训练的算法来预测个人犯罪行为的研究。 关键技术联盟说,这样的工作不仅在科学上是文盲,而...

- 发布于 2021-04-19 04:37

- 阅读 ( 178 )

华纳兄弟与一家声称能预测电影成功的人工智能初创公司签约

...在接受THR采访时,Cinelytic的首席执行官Tobias Queisser强调,人工智能只是一种辅助工具。“人工智能听起来很可怕。但现在,人工智能无法做出任何创造性的决定,”奎瑟告诉出版物。“它擅长的是处理数字,分解庞大的数据集,...

- 发布于 2021-04-20 13:10

- 阅读 ( 164 )

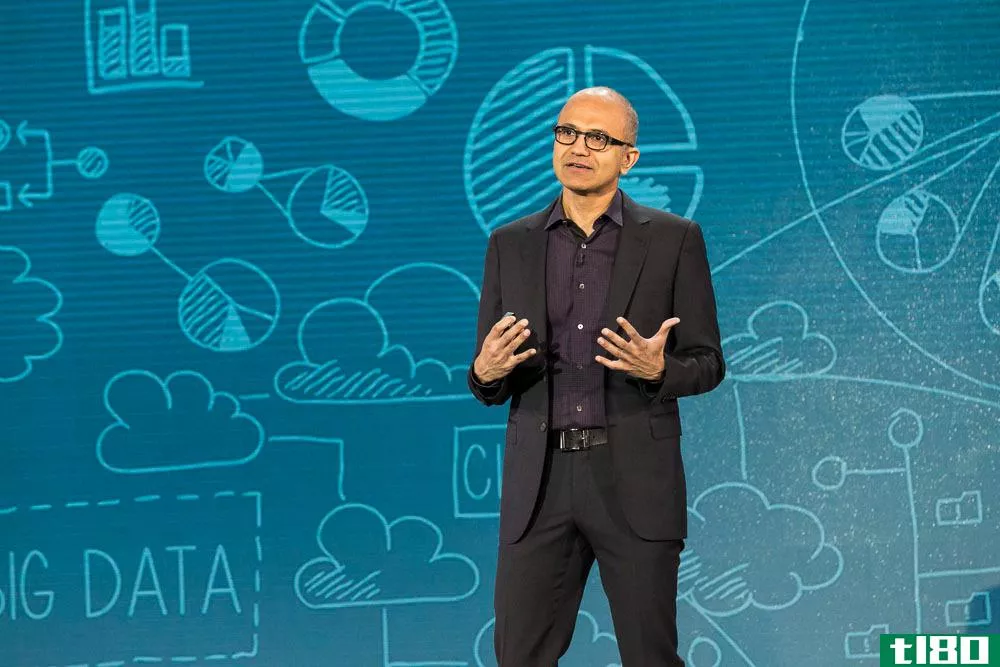

萨蒂亚纳德拉的人工智能规则比阿西莫夫的三定律更无聊(也更相关)

...定律)几十年来一直是科幻小说的忠实写照。不过,随着人工智能的最新进展,计算机科学家和科技公司开始认真考虑我们实际需要的规则,以保护自己免受未来机器人和人工智能的影响。上周,谷歌的研究人员发表了一篇科学...

- 发布于 2021-05-05 22:59

- 阅读 ( 359 )