人工智能在学习人类书写的东西时会发现种族和性别偏见

研究人员说,人工智能在从文本中学习语言时会发现种族和性别偏见。在没有任何监督的情况下,机器学习算法学会了将**名字与家庭词汇相关联,而不是与职业词汇相关联,将黑人名字与白人名字相关联。

在今天发表在《科学》杂志上的一项研究中,研究人员测试了一个普通人工智能模型的偏差,然后将结果与一个著名的心理测试进行比对,该测试测量了人类的偏差。研究合著者、普林斯顿大学博士后艾琳·卡利斯卡恩(Aylin Caliskan)表示,研究小组在算法中复制了他们测试的所有心理偏见。由于机器学习算法非常普遍,从翻译到扫描简历上的姓名,影响了一切,这项研究表明,偏见也是普遍存在的。

“语言是沟通思想的桥梁,很多算法都是建立在现实世界中的语言基础上的,”新美国加州分部主管梅根·加西亚(Megan Garcia)说,他曾写过这种所谓的算法偏见因此,除非alg只根据数字做出决定,否则这一发现将非常重要。”

算法是一组指令,人类写来帮助计算机学习。加州大学圣地亚哥分校的AI研究员扎查里·利普顿说,把它想象成一个食谱,他没有参与这项研究。因为算法使用现有的材料,比如网络上的书籍或文本,很明显,如果材料本身有偏见,人工智能会产生偏见(例如,谷歌照片把黑人用户标记为大猩猩。)我们有一段时间知道,例如,语言算法学会了将“男人”一词与“教授”和“女”一词与“助理教授”联系起来。但是这篇文章很有趣,因为它包含了以前在心理学中对人类偏见所做的工作,利普顿说。

在今天的研究中,Caliskan的团队创建了一个类似于内隐联想测试的测试,这在心理学中常用来衡量人们的偏见程度(尽管对它的准确性有一些争议)。在IAT中,受试者被呈现两个图像,比如说,一个白人和一个黑人,以及“令人愉快”或“不愉快”这样的词。IAT计算出你将“白人”和“令人愉快”与“黑人”和“令人愉快”匹配的速度,反之亦然。这个想法是,匹配两个概念的时间越长,将它们关联起来的麻烦就越大。

研究人员开发的测试也计算了偏差,但它不是测量“反应时间”,而是测量两个单词之间的数学距离。换句话说,如果一个黑名字和“令人愉快”的概念之间的数字距离比一个白名字和“令人愉快”之间的距离大,那么模型在两者之间的关联就没有那么强烈了。单词之间的距离越远,算法将它们联系在一起的次数就越少。

Caliskan的团队随后在一个特定的算法上测试了他们的方法:斯坦福大学的单词表示的全局向量(Global Vectors for Word Representation,手套)。手套基本上是在网络上搜寻数据,并学习数十亿个单词之间的关联。研究人员发现,在手套里,**单词更多地与艺术有关,而不是与数学或科学有关,黑名字比白名字更令人讨厌。这并不意味着人工智能系统本身有什么问题,也不意味着人工智能是如何学习的——材料有问题。

“人工智能是有偏见的,因为它反映了文化、世界和语言的影响,”卡利斯卡恩说因此,每当你训练一个关于人类历史数据的模型时,你最终会邀请那些数据所携带的任何东西,这可能是偏见或刻板印象。”一个限制是团队只能计算与单个单词相关的偏见。接下来,他们对扩展到多个单词或短语以及其他语言感兴趣。

卡利斯卡恩认为,解决办法不一定是改变模式。人工智能只是捕捉到了这个世界的本来面目——碰巧我们的世界充满了偏见。改变算法的工作方式会降低效率。利普顿说,不管怎样,隐瞒信息可能行不通。即使你不告诉模型某人是**还是**,你也会提供其他与性别相关的信息,模型很可能会找到答案。”我们不能想当然地认为任何形式的客观性,永远,”他说。

相反,人类可以在另一端工作。例如,可以调整Google Translate以改进其翻译。所以,如果你看到“医生”总是被翻译成“他”,而“护士”被翻译成“她”,你可以建议改变。

新上任的美国CA主管Garcia说,让更多不同的人参与构建算法可能也会有所帮助。但与此同时,她也认为,第一步只是鼓励大家记住,除非得到纠正,否则总会有偏见:“电脑产生的偏见无处不在。”

- 发表于 2021-05-10 17:27

- 阅读 ( 220 )

- 分类:互联网

你可能感兴趣的文章

偏执(bigotry)和偏见(prejudice)的区别

...理学家戈登·奥尔波特指出,偏见的出现在一定程度上是人类正常思维的结果。在我们今天的生活中,人们在脑海中创造了不同的类别。这种信息分类有助于人类理解世界。奥尔波特进一步解释说,正是这些分类构成了偏见的基...

- 发布于 2020-10-25 17:44

- 阅读 ( 367 )

由于对种族偏见的担忧,twitter计划改变图片裁剪的工作方式

...图像裁剪工作方式,此前有人担心该公司使用的基于机器学习的算法在裁剪图像时存在种族偏见,特别是偏爱白脸而非黑脸。 该公司首席技术官帕拉格•阿格拉瓦尔(Parag Agrawal)和设计总监丹特利•戴维斯(Dantley Da...

- 发布于 2021-04-17 12:06

- 阅读 ( 117 )

facebook将研究其算法是否存在种族偏见

...研究其主要社交网络和Instagram的种族偏见,特别是其使用人工智能训练的算法是否会对黑人、西班牙裔和其他代表性不足的群体产生不利影响。Facebook的一位发言人告诉Verge,这个团队将“负责确保我们所做的每件事都有公平和...

- 发布于 2021-04-18 15:08

- 阅读 ( 186 )

使用人工智能根据姓名来识别性别的服务看起来极为偏颇

...吃一惊。 Genderify是一项新的服务,它承诺在人工智能的帮助下,通过分析某人的姓名、电子邮件地址或用户名来识别其性别,它看起来肯定属于后者。该公司上周推出了产品搜索,但由于用户发现其算法存在偏差和...

- 发布于 2021-04-18 16:45

- 阅读 ( 154 )

亚马逊明年禁止警方使用其面部识别技术

...识别技术,理由是可能侵犯人权和隐私,研究表明,尽管人工智能取得了进展,但面部识别技术仍存在年龄、性别、种族和种族偏见。 许多揭示现代面部识别技术在种族偏见方面缺陷的基础性工作都要归功于麻省理工学院媒体...

- 发布于 2021-04-19 02:14

- 阅读 ( 204 )

一个机器学习工具能(也不能)告诉我们什么是人工智能偏见

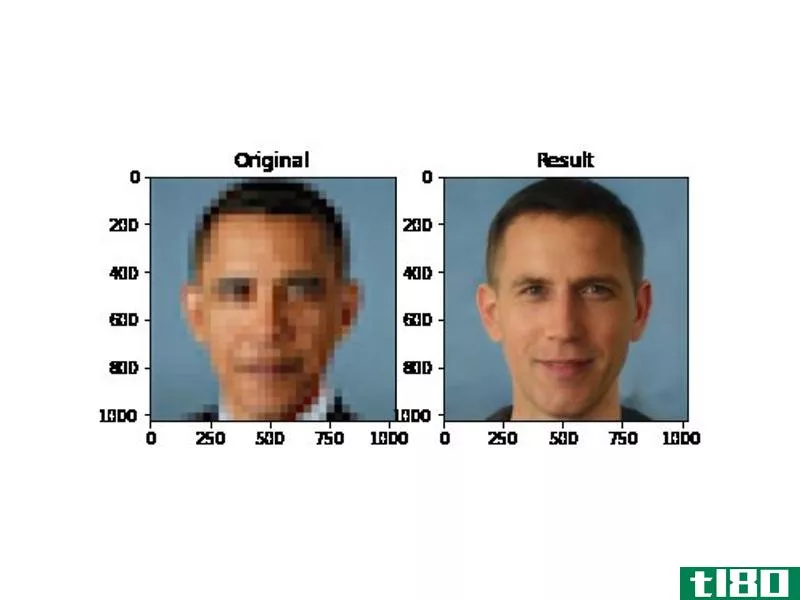

这是一个惊人的图像,说明了人工智能研究根深蒂固的偏见。将美国第一位黑人总统巴拉克奥巴马(Barack Obama)的一张低分辨率照片输入到一个算法中,该算法设计用于生成不相关的人脸,输出的是一个白人。 也不...

- 发布于 2021-04-19 04:02

- 阅读 ( 148 )

人工智能专家说,对声称能预测犯罪行为的算法的研究必须结束

一个由人工智能研究人员、数据科学家和社会学家组成的联盟呼吁学术界停止发表声称利用面部扫描和犯罪统计等数据训练的算法来预测个人犯罪行为的研究。 关键技术联盟说,这样的工作不仅在科学上是文盲,而...

- 发布于 2021-04-19 04:37

- 阅读 ( 178 )

是什么让人工智能具有种族歧视和性别歧视

人工智能正渗透到我们的日常生活中,应用程序可以管理你的**图片、管理你的电子邮件,以及将任何语言的文本翻译成另一种语言。谷歌、Facebook、苹果和微软都在大力研究如何将人工智能集成到它们的主要服务中。很快你就...

- 发布于 2021-05-15 20:43

- 阅读 ( 150 )

天文学中有很多偏见,有色人种的女性受到的伤害最大

...于妇女从事实地工作的经历的论文,作者是伊利诺伊大学人类学教授凯瑟琳·克兰西,也是这篇新论文的合著者。 但这是科学界第一个关注有色人种**的研究。 克兰西说:“我们正在追随有色人种**的脚步,她们几十年来一直试...

- 发布于 2021-05-29 00:58

- 阅读 ( 118 )

一项机器学习研究证实,电影对白常常强化对种族和性别的刻板印象

...中7000个人物的53000多个对话片段进行了研究,并利用机器学习来研究人物如何按照种族、性别和年龄线说话和互动。他们还检查了**影片的工作人员的构成,包括编剧、导演和演员经纪人。 这项研究有一些收获。首先,**角色比*...

- 发布于 2021-05-29 08:27

- 阅读 ( 342 )